Математические методы

Математическое моделирование физических процессов и математические методы анализа данных являются неотъемлемой частью современной экспериментальной физики. Постоянно возникает потребность как в совершенствовании существующих методов, так и в разработке принципиально новых подходов.

Статистическая регуляризация некорректных обратных задач

Одной из задач, решаемых группой, является популяризация и развитие метода статистической регуляризации, созданного В.Ф. Турчиным в 70-х годах XX века.

Типичной некорректной обратной задачей, возникающей в физике, является уравнение Фредгольма I рода:

Фактически, это уравнение описывает следующее: аппаратная функция прибора действует на исследуемый спектр или иной входной сигнал , в результате чего исследователь наблюдает выходной сигнал . Целью исследователя является восстановить сигнал по известным и . Казалось бы, восстановление сигнала не является сложной задачей, поскольку уравнение Фредгольма имеет точное решение. Но уравнение Фредгольма некорректно — бесконечно малое изменение начальных условий приводит к конечному изменению решения. Таким образом, наличие шумов, присутствующих в любом эксперименте, обесценивает попытки решить это уравнение точно.

Теория

Рассмотрим некую алгебраизацию уравнения Фредгольма:

С точки зрения математической статистики мы должны оценить по реализации , зная плотность вероятности для и содержимое матрицы . Действуя в духе теории принятия решений, мы должны выбрать вектор-функцию , определяющую на основе и называемую стратегией. Для того чтобы определить, какие стратегии более оптимальные, мы введем квадратичную функцию потерь:

где — наилучшее решение. Согласно байесовскому подходу рассмотрим как случайную переменную и переместим нашу неопределенность о в априорную плотность , выражающую достоверность различных возможных законов природы и определяемую на основе информации, сущетсвующей до проведения эксперимента. При таком подходе выбор оптимальной стратегии основывается на минимизации апостериорного риска:

Тогда оптимальная стратегия в случае квадратичной функции потерь хорошо известна:

Апостериорная плотность определяется по теореме Байеса:

Кроме того, такой подход позволяет определить дисперсию полученного решения:

Мы получили решение, введя априорную плотность . Можем ли мы сказать, что-либо о том мире функций , который задается априорной плотностью? Если ответ на этот вопрос отрицательный, то мы должны будем принять все возможные равновероятными и вернуться к нерегуляризованному решению. Таким образом, мы должны ответить на этот вопрос положительно. Именно в этом заключается метод статистической регуляризации — регуляризация решения за счет введения дополнительной априорной информации о . Если исследователь уже обладает какой-либо априорной информацией (априорной плотностью ), он может просто вычислить интеграл и получить ответ. В случае, если такой информации нет, в следующем параграфе описывается, какой минимальной информацией может обладать исследователь и как её использовать для получения регуляризованного решения.

Априорная информация

Как показали британские ученые, во всем остальном мире любят дифференцировать. Причем, если математик будет задаваться вопросами о правомерности этой операции, то физик оптимистично верит, что законы природы описываются «хорошим» функциями, то есть гладкими. Иначе говоря, он назначает более гладким более высокую априорную плотность вероятности. Так давайте попробуем ввести априорную вероятность, основанную на гладкости. Для этого мы вспомним, что введение априорной информации — это некоторое насилие над миром, принуждающее законы природы выглядеть удобным для нас образом. Это насилие следует свести к минимуму, и, вводя априорную плотность вероятности, необходимо, что бы информация Шеннона относительно , содержащаяся в , была минимальной. Формализуя выше сказанное, выведем вид априорной плотности, основанной на гладкости функции. Для этого мы будем искать условный экстремум информации:

При следующих условиях:

- Условие на гладкость . Пусть — некоторая матрица, характеризующая гладкость функции. Тогда потребуем, чтобы достигалось определённое значение функционала гладкости:

Внимательный читатель должен задать вопрос об определении значения параметра . Ответ на него будет дан далее по тексту.

- Нормированность вероятности на единицу:

При этих условиях доставлять минимум функционалу будет следующая функция:

Параметр связан с , но поскольку у нас нет собственно информации о конкретных значениях функционала гладкости, выяснять, как именно он связан, бессмысленно. Что же тогда делать с , спросите вы? Здесь перед вами раскрываются три пути:

- Подбирать значение параметра вручную, и тем самым перейти к регуляризации Тихонова

- Усреднить по всем возможным , предполагая все возможные равновероятными

- Выбрать наиболее вероятное по его апостериорной плотности вероятности . Этот подход верен, если мы предполагаем, что в экспериментальных данных содержится достаточно информации об .

Первый случай нам малоинтересен. Во втором случае мы получим следующую формулу для решения:

Третий случай будет рассмотрен в следующем разделе на примере гауссовых шумов в эксперименте.

Случай гауссовых шумов

Случай, когда ошибки в эксперименте распределены по Гауссу, замечателен тем, что можно получить аналитическое решение нашей задачи. Решение и его ошибка будут иметь следующий вид:

где — ковариационная матрица многомерного распределения Гаусса, — наиболее вероятное значение параметра , которое определяется из условия максимума апостериорной плотности вероятности:

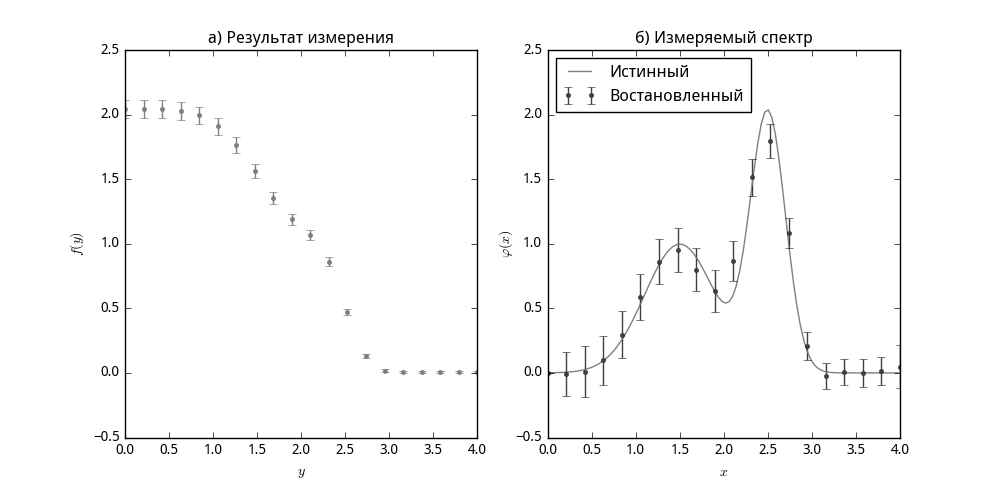

В качестве примера рассмотрим восстановление спектра, состоящего из двух гауссовых пиков, которые попали под действие интегрального ядра-ступеньки (функции Хевисайда).

Оптимальное планирование эксперимента при помощи функций значимости параметров